瑞芯微RK3399Pro——适合深度学习的AI芯片这一

2020-10-13 15:20:20

机器学习,特别是深度学习技术正在推动人工智能(AI)的发展。 一开始,深度学习主要是软件游戏。 从2016年开始,学术界和工业界对AI / ML / DL的更高效硬件加速的需求得到了认可。 今年,我们看到越来越多的参与者,包括世界顶级半导体公司以及一些初创公司,甚至是科技巨头谷歌,也纷纷加入竞争。

英特尔——Nervana

英特尔收购了Nervana Systems,除了Nervana Engine ASIC之外,他还开发了GPU /软件方法。 可比性能尚不清楚。 英特尔还计划通过Knights Crest项目整合到Phi平台。 NextPlatforms建议,对于某些宽度的OP,28nm的2017目标可能是55 TOPS / s。 英特尔计划于12月推出NervanaCon,所以也许我们会看到第一批成果。

英特尔 Nervana 神经网络处理器(NNP)重新定义AI。

Mobileye EyeQ

Movidius

Myriad X是第一款采用神经计算引擎的VPU,这是一种用于运行设备上深度神经网络应用的专用硬件加速器。

FPGA

英特尔FPGA OpenCL和解决方案。

Loihi

英特尔的Loihi测试芯片是首款自学芯片。

高通——Nvidia

Qualcomm人工智能引擎为Snapdragon移动平台提供AI功能。Nvidia的最新GPU可以执行15个TFlops的SP或120个TFlops,其新的Tensor核心架构是FP16乘法和FP32累积或增加以适应ML。

SoC

在边缘,Nvidia提供NVIDIA DRIVE?PX,用于自动驾驶的AI车载计算机和JETSON TX1 / TX2 MODULE,“用于自主一切的嵌入式平台”。

NVDLA

Nvidia在GTC2017上获得了“XAVIER DLA NOW OPEN SOURCE”。 我们还没有看到Early Access版本。

NVIDIA深度学习加速器(NVDLA)是一种免费开放式架构,旨在促进设计深度学习推理加速器的标准方法。 凭借其模块化架构,NVDLA具有可扩展性,高度可配置性,旨在简化集成和可移植性。 硬件支持各种物联网设备。

三星

三星热烈推出“新款Exynos 9810带有2.9GHz定制CPU的高级功能,业界首款6CA LTE调制解调器和深度学习处理功能”。

AMD

即将发布的AMD Radeon Instinct MI25承诺提供12.3 TFlops SP或24.6 TFlops FP16。 如果你的计算适合Nvidia的Tensors,那么AMD就无法参与竞争。 Nvidia的带宽为900GB / s,而AMD为484 GB / s。

AMD九年来首次将非常好的X86服务器处理器推向市场,并且它还具有匹配的GPU,为其OEM和ODM合作伙伴提供了一个可靠的替代方案,可将HPC和AI工作负载转换为Intel Xeon和Nvidia的组合 特斯拉这些天主导着混合计算。

XILINX

Xilinx提供“从边缘到云的机器学习推理解决方案”,并且自然地声称他们的FPGA最适合INT8和他们的白皮书。

虽然FPGA的每瓦特性能令人印象深刻,但供应商的大型芯片长期以来一直在为更大的芯片提供惊人的高芯片价格。 在价格和功能之间找到平衡是FPGA面临的主要挑战。

IBM

TrueNorth是与DARPA SyNAPSE计划一起开发的IBM的Neuromorphic CMOS ASIC。它是一个芯片设计的多核处理器网络,具有4096个核心,每个核心模拟256个可编程硅“神经元”,总共只有超过一百万个神经元。

NXP——ADAS芯片

S32V234:用于前置和环绕视觉相机,机器学习和传感器融合应用的视觉处理器。

联发科

联发科技为跨平台消费者设备推出其边缘人工智能平台和人工智能技术。通过硬件和软件,人工智能处理单元(APU;人工智能处理单元)和NeuroPilot SDK的组合,联发科技将把AI带入其广泛的技术组合 - 这一组合每年为智能手机提供15亿个消费产品, 智能家居,汽车等。

海思

麒麟智能手机

HiSilicon Kirin 970处理器通过专用的神经网络处理单元进行了宣传。

移动相机SoC

根据Hi3559A V100ESultra-HD移动相机SoC的简要数据表,它具有:双核CNN @ 700 MHz神经网络加速引擎。

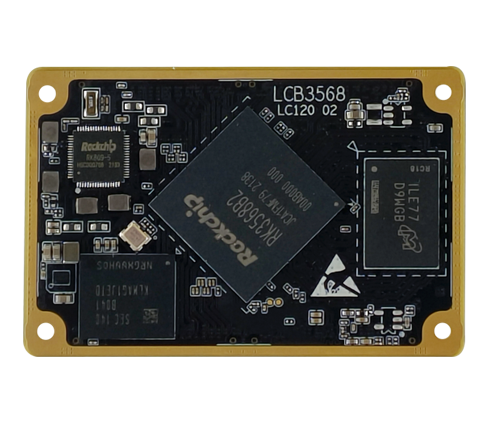

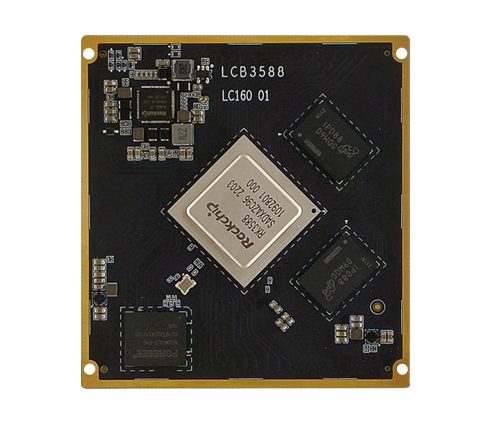

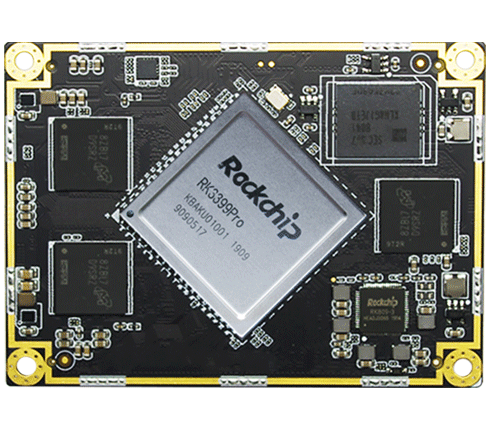

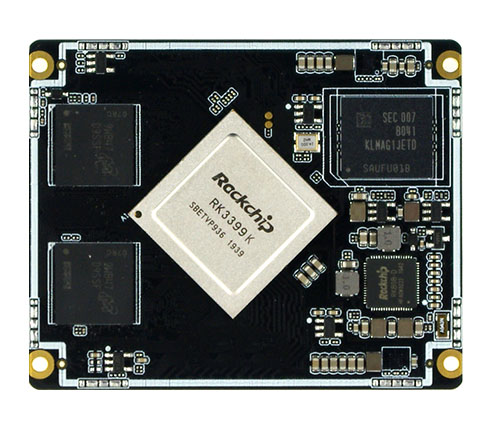

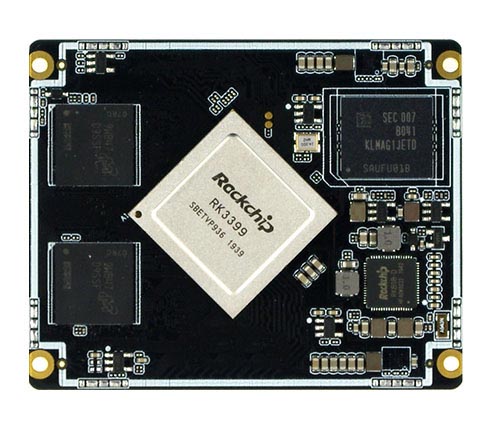

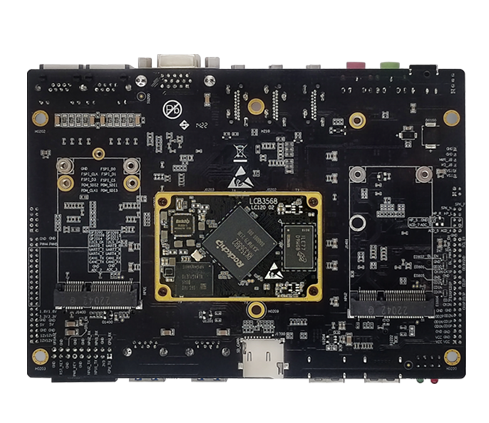

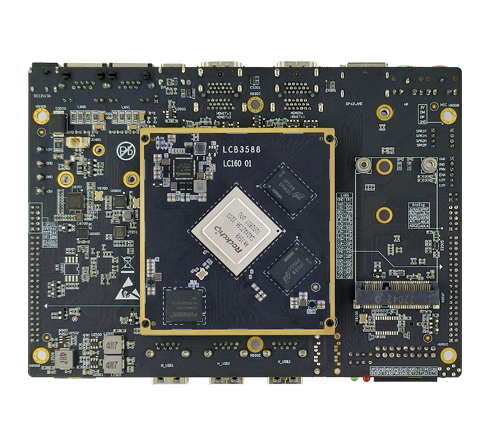

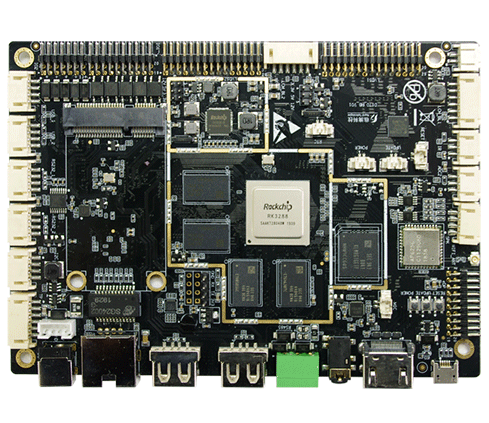

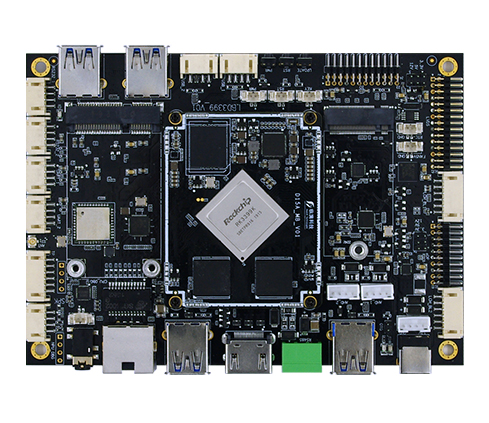

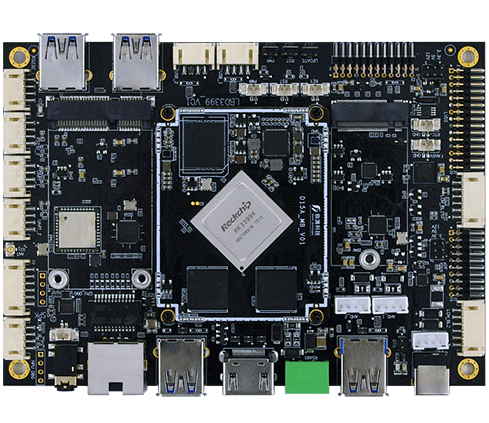

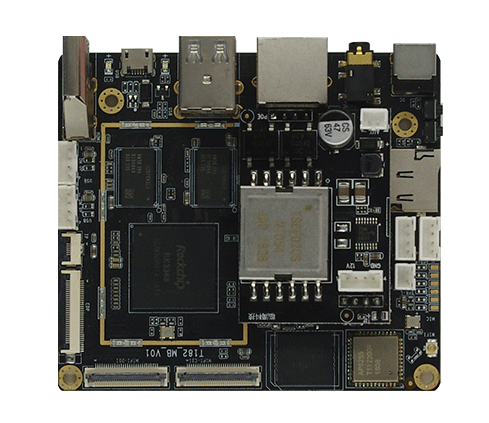

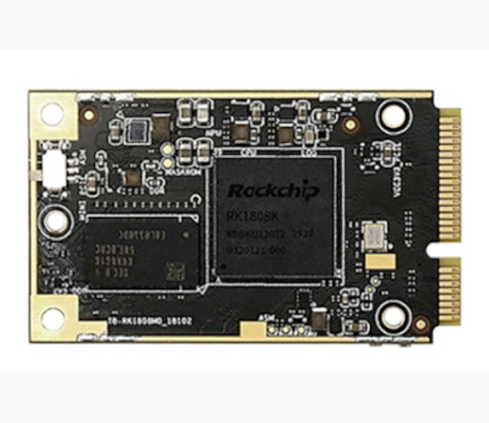

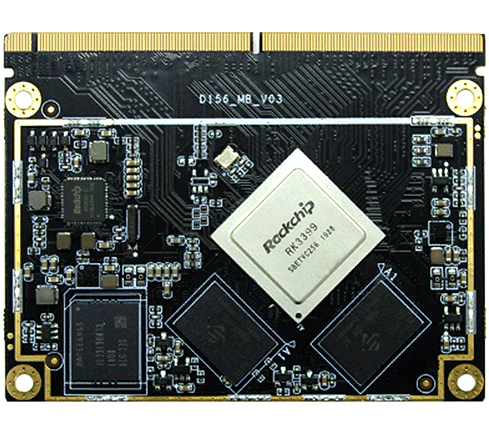

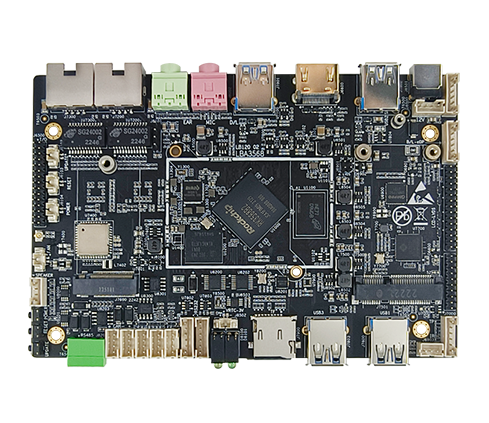

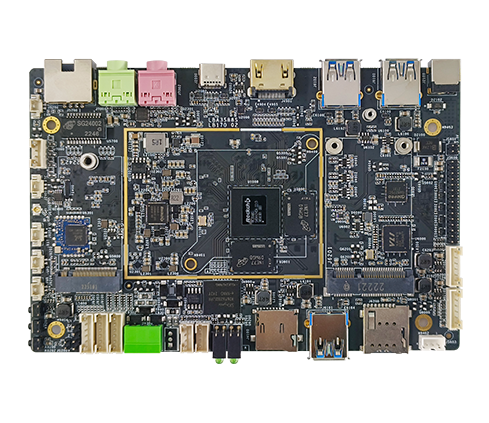

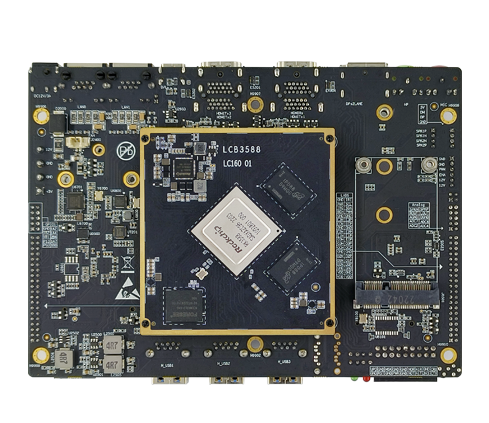

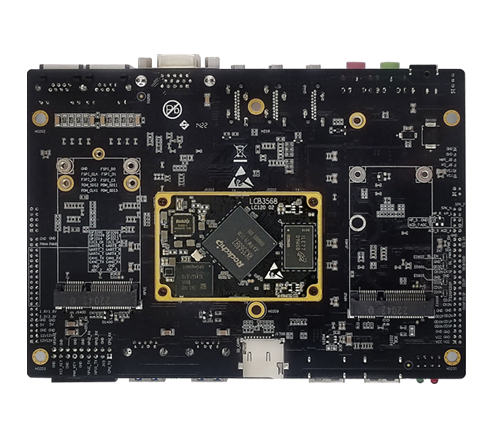

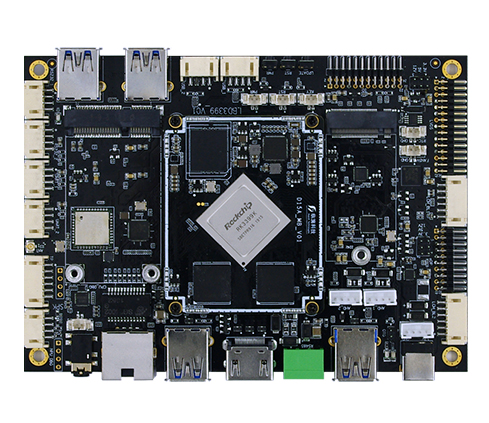

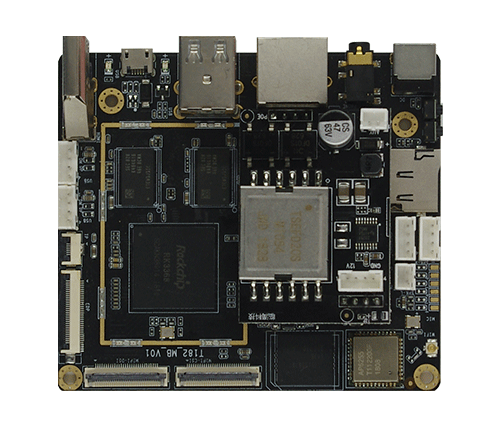

瑞芯微

瑞芯微推出首款人工智能处理器RK3399Pro - NPU性能高达3.0TOP

谷歌

谷歌的原始TPU在GPU上取得了很大的领先优势,并帮助DeepMind的AlphaGo在Go锦标赛中击败了Lee Sedol。

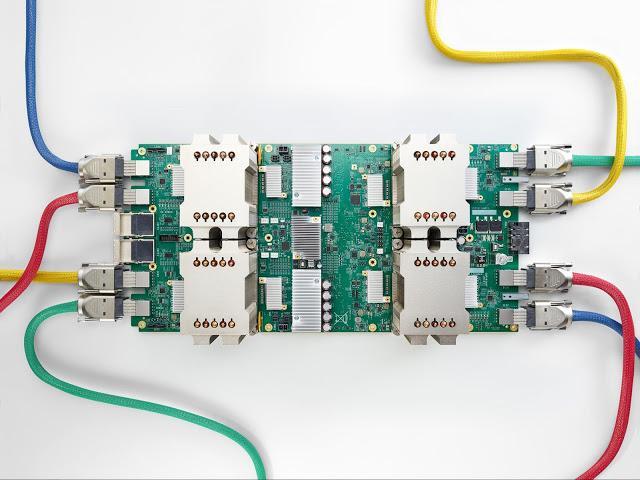

谷歌在2017年I/O大会上已经明确喊出“AI First”(人工智能优先)的口号,在今年的IO大会上,谷歌推出了第三代TPU。根据官方介绍,TPU3.0的计算能力最高可达100PFlops,是TPU2.0的8倍多。它是谷歌自主研发的针对深度学习加速的专用人工智能芯片。TPU是专为谷歌深度学习框架TensorFlow设计的人工智能芯片。著名的AlphaGo使用的就是TPU2.0芯片。

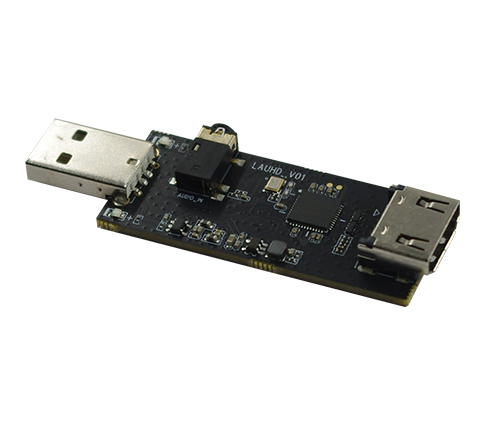

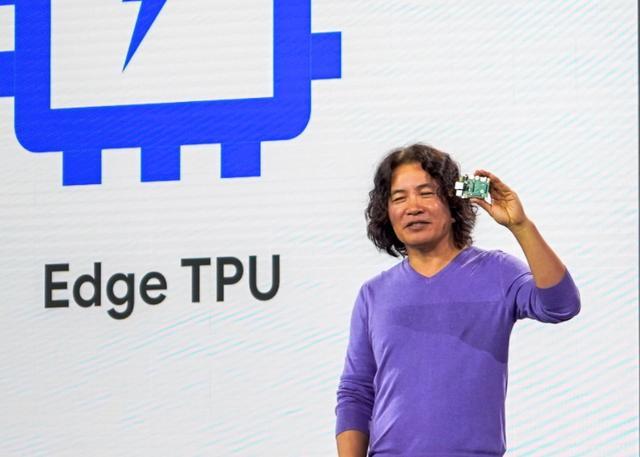

此外,谷歌还发布了Edge TPU,特定用途 ASIC 芯片,专为在设备上运行 TensorFlow Lite ML 模型而设计。针对Edge TPU的新设备是:AIY Edge TPU Dev 开发板和 AIY Edge TPU 加速器,二者皆采用 Google 的 Edge TPU 芯片。

亚马逊

亚马逊可能正在为Alexa开发AI芯片。

该信息今天上午有一份报告称亚马逊正致力于为Echo构建AI芯片,这将使Alexa能够更快地解析信息并获得这些答案。

AWS

Amazon EC2 F1是具有现场可编程门阵列(FPGA)的计算实例,您可以对其进行编程以为您的应用创建自定义硬件加速。

微软

有线电视在MSFT上使用FPGA也做了一个很好的故事,“微软在可重编程计算机芯片上迎合它的未来”。如果想要了解微软对云中FPGA的愿景,那么基于Microsoft FPGA的可配置云内部也是一个很好的参考。

苹果

苹果推出新款处理器,为新款iPhone 8和iPhone X - A11 Bionic提供动力。 A11还包括Apple称为“神经引擎”的专用神经网络硬件,每秒可执行高达6000亿次操作。Core ML是Apple目前对机器学习应用的热衷。

Facebook正在组建一个团队来设计自己的芯片。Facebook公司正在建立一个团队来设计自己的芯片,这增加了科技公司提供自我供应的趋势,并降低了对英特尔和高通公司等芯片制造商的依赖,据业内人士和熟悉此事的人士表示